Entendendo o paradigma da IA agêntica

Quando a IA generativa se tornou mainstream, a AWS lançou a Matriz de Escopo de Segurança para IA Generativa para ajudar organizações a compreender e lidar com os desafios únicos de segurança em aplicações baseadas em modelos de fundação. Esse framework foi amplamente adotado não apenas por clientes da AWS, mas também referenciado por organizações como OWASP, CoSAI e outros órgãos de padronização da indústria, parceiros e integradores de sistemas.

Agora, conforme sistemas de IA agêntica com capacidades de chamadas de funções e tomada de decisão autônoma emergem, surge a necessidade de um framework complementar para lidar com um conjunto totalmente novo de desafios de segurança. Diferentemente dos modelos de fundação tradicionais que operam em padrões previsíveis de solicitação e resposta, os sistemas agênticos introduzem capacidades autônomas, memória persistente, orquestração de ferramentas, desafios de identidade e agência, além de integração com sistemas externos. Isso expande significativamente os riscos que as organizações precisam gerenciar.

Sistemas de IA agêntica podem executar tarefas multietapas de forma autônoma, tomar decisões e interagir com infraestrutura e dados. Essa transformação fundamental exige que as organizações se adaptem a uma realidade diferente daquela dos modelos de fundação convencionais. Após trabalhar com clientes que implementam esses sistemas, observou-se que os frameworks tradicionais de segurança em IA nem sempre se estendem adequadamente para o espaço agêntico. A natureza autônoma desses sistemas demanda abordagens de segurança fundamentalmente diferentes.

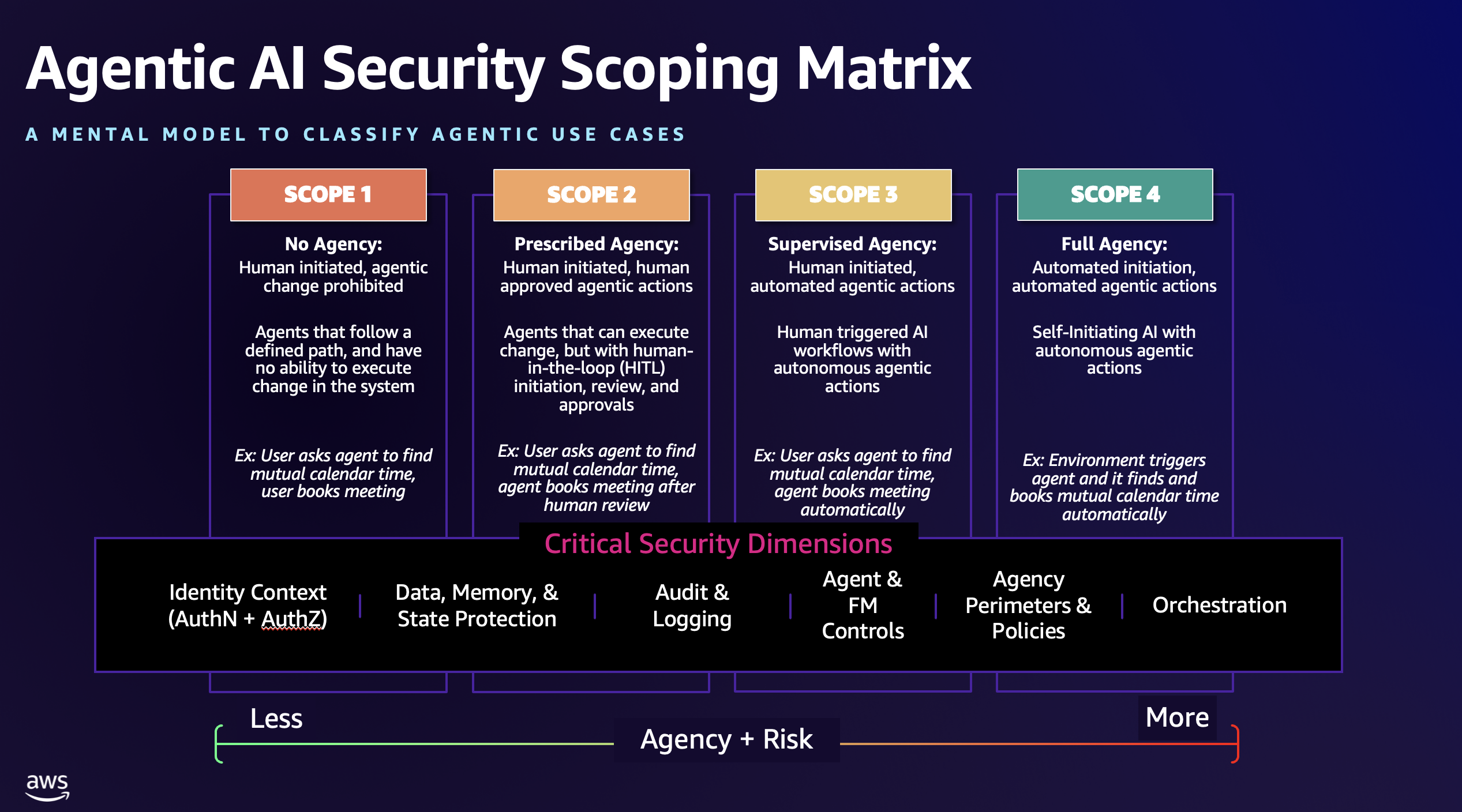

Para preencher essa lacuna, a AWS desenvolveu a Matriz de Escopo de Segurança para IA Agêntica: um modelo conceitual e um framework que categoriza quatro arquiteturas agênticas distintas com base em níveis de conectividade e autonomia, mapeando controles críticos de segurança em cada uma delas.

Distinção entre agência e autonomia

Os sistemas de IA generativa tradicional funcionam em um padrão bem compreendido e previsível: recebem uma instrução ou prompt, geram uma resposta e encerram a sessão. Controles de segurança e conformidade focam em medidas básicas como validação de entrada, filtragem de saída e guardrails de moderação de conteúdo. Esse modelo funciona porque as falhas de segurança têm escopo limitado — uma interação comprometida afeta apenas aquele request e response específico, sem persistir ou se propagar para outros sistemas ou usuários.

Sistemas agênticos transformam fundamentalmente esse modelo de segurança. Agentes iniciadores podem agir com base em objetivos e gatilhos ambientais que podem ou não exigir prompts humanos ou aprovação. Isso cria riscos de ações não autorizadas, processos descontrolados e decisões que extrapolam os limites pretendidos quando agentes interpretam incorretamente objetivos ou operam com instruções comprometidas.

Ao discutir IA agêntica, é essencial esclarecer a distinção entre dois conceitos relacionados mas distintos: agência e autonomia. Esses conceitos informam diretamente a estratégia de segurança.

Agência refere-se ao escopo de ações que um sistema de IA é autorizado e capaz de executar dentro do ambiente operacional, e quanto um humano delimita as ações ou capacidades do agente. Inclui quais sistemas ele pode interagir, quais operações pode realizar e quais recursos pode modificar. Agência é fundamentalmente sobre capacidades e permissões — o que o sistema está autorizado a fazer.

Autonomia, em contraste, refere-se ao grau de tomada de decisão e ação independente que o sistema pode exercer sem intervenção humana. Inclui quando opera, como escolhe entre ações disponíveis e se requer aprovação humana para execução. Autonomia é sobre independência na tomada de decisão e execução — com quanto liberalismo o sistema pode agir dentro de sua agência concedida.

Por exemplo, um agente de IA pode ter alta agência (capaz de executar muitas ações) mas baixa autonomia (exigindo aprovação humana para cada ação), ou vice-versa. Compreender essa distinção é fundamental para implementar controles de segurança apropriados. Agência requer sistemas de fronteiras e permissões, enquanto autonomia requer mecanismos de supervisão e controles comportamentais.

Capacidades centrais dos sistemas agênticos e seus riscos

Vários fatores chave diferenciam os sistemas agênticos dos modelos tradicionais e ampliam os desafios de segurança:

Execução autônoma e agência: Agentes podem iniciar ações com base em objetivos e gatilhos ambientais, criando riscos de ações não autorizadas e processos descontrolados quando agentes interpretam incorretamente objetivos ou operam com instruções comprometidas.

Memória persistente: Agentes frequentemente mantêm contexto e comportamentos aprendidos entre sessões, construindo bases de conhecimento que informam decisões futuras. Essa persistência de dados introduz requisitos adicionais de proteção de dados e novos vetores de risco, como ataques de envenenamento de memória, onde adversários injetam informações falsas que corrompem a tomada de decisão entre múltiplas interações e usuários.

Orquestração de ferramentas: Agentes se integram diretamente via funções com conexões a bancos de dados, APIs, serviços e potencialmente outros agentes. Essa superfície de ataque expandida cria riscos de compromissos em cascata, onde uma única falha em um agente pode se propagar através de sistemas conectados, workflows multiagente e serviços e armazenamentos de dados a jusante.

Conectividade externa: Agentes operam através de limites de rede, acessando recursos da internet, APIs de terceiros e sistemas empresariais. Essa conectividade expandida pode desbloquear novo valor comercial, mas deve ser projetada com controles de segurança que limitem riscos como exfiltração de dados, movimento lateral e manipulação externa.

Comportamento autodirecionado: Agentes avançados podem iniciar atividades com base no monitoramento ambiental, agendamento ou padrões aprendidos, sem instanciação ou revisão humana. Essa autodireção introduz riscos de operações descontroladas, explicabilidade limitada e auditabilidade reduzida, dificultando a manutenção de fronteiras de segurança previsíveis.

A Matriz de Escopo de Segurança para IA Agêntica

Trabalhando com clientes e a comunidade, a AWS identificou quatro escopos arquiteturais que representam a evolução dos sistemas de IA agêntica, baseados em duas dimensões críticas: o nível de supervisão humana comparado à autonomia e o nível de agência que o sistema de IA tem permissão para exercer. Cada escopo introduz novas capacidades — e requisitos de segurança correspondentes — que as organizações devem priorizar ao lidar com riscos agênticos.

Escopo 1: Sem agência

Neste escopo mais básico, os sistemas operam com processos iniciados por humanos e nenhuma capacidade de mudança autônoma ou mesmo aprovada por humanos através do agente. Os agentes são, essencialmente, apenas leitura. Esses sistemas seguem caminhos de execução predefinidos e operam sob workflows rigorosamente acionados por humanos, geralmente predefinidos e com etapas discretas.

O foco de segurança é primariamente na integridade do processo e na aplicação de limites, ajudando operações a permanecerem dentro de limites predeterminados. Agentes são altamente controlados e proibidos de executar mudanças e ações sem limites.

Características principais: Agentes não podem executar mudanças diretas no ambiente, execução passo a passo seguindo caminhos predeterminados, componentes de IA generativa processam dados dentro de nós individuais de workflow, ramificação condicional apenas onde explicitamente projetada no workflow, nenhum comportamento de planejamento dinâmico ou busca autônoma de objetivos, persistência de estado limitada ao contexto de execução de workflow, acesso a ferramentas restrito a etapas específicas de workflow predefinidas.

Foco de segurança: Proteger integridade de dados dentro do ambiente e restringir agentes para não exceder limites, especialmente em relação à modificação de ambiente e dados. As preocupações primárias incluem asegurar transições de estado entre etapas, validar dados passados entre nós de workflow e prevenir componentes de IA de modificarem a lógica de orquestração ou escaparem de seus limites designados.

Exemplo: Imagine um agente projetado para ajudar na criação de convites de calendário. No Escopo 1, você instancia um agente através de um workflow para examinar seu calendário e o de um colega em busca de horários disponíveis. O agente executa uma busca contextual usando um servidor Model Context Protocol conectado à aplicação de calendário empresarial. Ele só tem permissão para consultar horários disponíveis, analisar os melhores momentos para encontro e fornecer uma resposta, que você então usa manualmente para agendar a reunião. Neste exemplo, o humano define workflows específicos (sem agência) e revisa e aprova ações (sem mudança autônoma).

Escopo 2: Agência prescrita

Movendo-se para cima em agência e risco, sistemas de Escopo 2 também são instanciados por um humano, mas agora têm potencial para executar ações — agência limitada — que poderiam alterar o ambiente. Contudo, todas as ações executadas por um agente requerem aprovação humana explícita para todas as ações de consequência, comumente referida como human-in-the-loop (HITL).

Esses sistemas podem coletar informações, analisar dados e preparar recomendações, mas não podem executar ações que modifiquem sistemas externos ou acessem recursos sensíveis sem autorização humana. Agentes também podem solicitar entrada humana para esclarecer ambiguidades, fornecer contexto faltante ou otimizar sua abordagem antes de apresentar recomendações.

Características principais: Agentes podem executar mudanças no ambiente com revisão e aprovação humana, supervisão humana em tempo real com workflows de aprovação, interação bidirecional humano-agente, ações autônomas limitadas a operações apenas leitura, solicitações iniciadas pelo agente para esclarecimento ou informação adicional, trilhas de auditoria de todas as decisões de aprovação humana.

Foco de segurança: Implementar workflows de aprovação robustos e prevenir agentes de contornarem controles de autorização humana. Preocupações chave incluem prevenir escalação de privilégios, aplicar contextos de identidade apropriados, asegurar o processo de aprovação, validar contexto fornecido por humano para prevenir ataques de injeção, e manter visibilidade em todas as recomendações de agente e seu raciocínio.

Exemplo: Um sistema agêntico de Escopo 2 é instanciado por um humano. O agente consulta disponibilidade do calendário das partes interessadas, realiza sua análise e retorna uma recomendação de horário para reunião ao usuário, perguntando se o usuário quer que o agente envie o convite em seu nome. O usuário revisa a resposta e recomendação do agente, valida se atende seus requisitos e então reconhece e aprova a solicitação do agente de modificar os calendários e enviar o convite. Neste exemplo, o humano orquestra um workflow estruturado, mas o agente agora pode instanciar mudança revisada por humano através de ações delimitadas (agência limitada e autonomia limitada).

Escopo 3: Agência supervisionada

No Escopo 3, expande-se a agência para permitir um grau maior de autonomia agêntica — agência alta — na execução. Esses são sistemas de IA que executam tarefas autônomas complexas iniciadas por humanos, com a capacidade de tomar decisões e executar ações em sistemas conectados sem aprovação ou mecanismos de HITL adicionais.

Humanos definem objetivos e disparam execução, mas agentes operam independentemente para alcançar objetivos através de planejamento dinâmico e uso de ferramentas. Durante execução, agentes podem solicitar orientação humana para otimizar trajetória ou lidar com casos extremos, embora possam continuar operando sem ela.

Características principais: Agentes podem executar mudanças no ambiente sem interação ou revisão humana adicional (ou opcionalmente), execução acionada por humano com conclusão autônoma de tarefa, planejamento dinâmico e tomada de decisão durante execução, pontos opcionais de intervenção humana para otimização de trajetória, capacidade humana de ajustar parâmetros ou fornecer contexto durante execução, acesso direto a APIs e sistemas externos para conclusão de tarefa, memória persistente entre sessões de execução estendida, seleção e orquestração autônoma de ferramentas dentro de limites definidos.

Foco de segurança: Implementar monitoramento abrangente de ações do agente durante fases de execução autônoma e estabelecer limites claros de agência para operações agentes. Preocupações críticas incluem asegurar o canal de intervenção humana para prevenir modificações não autorizadas, prevenir aumento de escopo durante execução de tarefa, implementar construtos de propagação de identidade confiável, monitorar anomalias comportamentais e validar que agentes permanecem alinhados com intenção humana original mesmo quando ajustes de trajetória são feitos.

Exemplo: Um sistema agêntico de Escopo 3 ainda é instanciado por um humano. O agente consulta disponibilidade do calendário das partes interessadas, realiza análise e retorna uma recomendação de horário para reunião ao usuário. Contudo, está dentro dos limites do agente atuar sobre sua própria recomendação em nome do usuário para automaticamente agendar o melhor slot disponível. O usuário não é solicitado ou se espera que dê permissão ao agente para isso antes de suas ações. O resultado é que todas as partes interessadas têm uma entrada de calendário adicionada em seu calendário no contexto do usuário chamador. Neste exemplo, o humano define um resultado mas com mais liberdade para o agente determinar como alcançar aquele objetivo, e o agente agora pode executar ação autônoma sem revisão humana (agência alta e autonomia alta).

Escopo 4: Agência completa

O Escopo 4 inclui sistemas de IA totalmente autônomos que podem iniciar suas próprias atividades com base no monitoramento ambiental, padrões aprendidos ou condições predefinidas, e executar tarefas complexas sem intervenção humana. Esses sistemas representam o mais alto nível de agência de IA, operando continuamente e tomando decisões independentes sobre quando e como agir.

É crucial notar que sistemas de IA dentro do Escopo 4 poderiam ter agência completa ao executar dentro de seus limites designados; portanto, é essencial que humanos mantenham supervisão de vigilância com capacidade de fornecer orientação estratégica, correções de curso ou intervenções quando necessário. Mecanismos contínuos de conformidade, auditoria e gerenciamento de ciclo de vida completo — tanto revisões humanas quanto automatizadas, potencialmente auxiliadas por IA — são críticos para asegurar e governar sistemas agênticos de Escopo 4 enquanto se limitam os riscos.

Características principais: Iniciação de atividades autodirecionadas com base em gatilhos ambientais, operação contínua com supervisão humana mínima durante execução, capacidade humana de injetar orientação estratégica sem interromper operações, altos a plenos graus de autonomia em definição de objetivo, planejamento e execução, interação dinâmica com múltiplos sistemas e agentes externos, capacidade para auto-melhoria recursiva e expansão de capacidade.

Foco de segurança: Implementar guardrails avançados para monitoramento comportamental, detecção de anomalias, controles de acesso a ferramentas baseados em escopo e mecanismos à prova de falha para prevenir operações descontroladas. Preocupações primárias incluem manter alinhamento com objetivos organizacionais, asegurar canais de intervenção humana contra manipulação adversarial, prevenir expansão de capacidade não autorizada, prevenir que mecanismos de supervisão humana sejam desabilitados pelo agente e permitir degradação graciosa quando agentes encontram situações inesperadas.

Exemplo: Considere como nosso exemplo de calendário poderia ser deployado em Escopo 4. Suponha que você tenha implementado um sumarizador de IA generativa para reunião. Esse agente é habilitado automaticamente quando você hospeda uma videoconferência. Ao fim da reunião, o agente sumarizador observa uma nova reunião que ocorreu e o agente de calendário vê isso. Ele examina itens de ação que foram sumarizados e determina que seis pessoas concordaram em uma sessão de whiteboarding na sexta. O agente de calendário poderia ter uma configuração de API estaticamente definida ou alavancar descoberta dinâmica em servidores MCP para ajudar com calendário. Ele então encontra disponibilidade para os seis recursos identificados e agenda o melhor slot. Usa então o contexto de identidade apropriado do usuário solicitando a reunião para agendar a reunião autonomamente. Em nenhum ponto um usuário instancia diretamente a solicitação de calendário; é totalmente automatizado e acionado por mudanças ambientais que o agente é instruído a buscar (agência completa e autonomia completa).

Dimensões críticas de segurança entre escopos

À medida que as organizações progridem pelos escopos, os requisitos de segurança aumentam em complexidade e escopo. Seis dimensões críticas de segurança devem ser consideradas:

Contexto de identidade (autenticação e autorização): Do Escopo 1 ao 4, evoluindo de autenticação básica de usuário para autenticação de serviço, delegação de identidade para ações autônomas, dinamicidade completa de ciclo de vida de identidade e autenticação federada.

Proteção de dados, memória e estado: Começando com permissões de recurso local e controle de acesso ao sistema de arquivos, progredindo para autorização baseada em função, elevação de privilégio just-in-time e finalmente para controles de autorização adaptativos e validação de autorização contínua.

Auditoria e logging: Evoluindo de logs de atividade local para trilhas de auditoria de decisão humana, captura de cadeia de raciocínio agente, logging comportamental contínuo e análise preditiva.

Controles de agente e modelo de fundação: Isolamento de processo em Escopo 1 progredindo para análise comportamental e detecção de anomalias em escopos posteriores, com contenção automatizada em Escopos 3 e 4.

Perímetros de agência e políticas: Limites de execução fixa em Escopo 1 evoluindo para ajuste de limite dinamicamente e adaptação autônoma em Escopos 3 e 4.

Orquestração: Orquestração simples de workflow em Escopo 1 progredindo para descoberta dinâmica de serviço e aprendizado entre sessões em Escopos 3 e 4.

Implementação de padrões arquiteturais bem-sucedidos

Deployments bem-sucedidos de sistemas agênticos compartilham padrões comuns que balanceiam autonomia com controle:

Deployment progressivo de autonomia: Iniciar com implementações de Escopo 1 ou 2 e gradualmente avançar pelos escopos conforme a confiança organizacional e capacidades de segurança amadurecem. Essa abordagem minimiza risco enquanto constrói experiência operacional. Seja cauteloso e seletivo ao analisar casos de uso e definir limites de controle para implementações de Escopo 4.

Arquitetura de segurança em camadas: Implementar defesa em profundidade com controles de segurança em múltiplos níveis — rede, aplicação, agente e camadas de dados. Esforce-se particularmente em endereçar preocupações de identidade e autorização para máquinas e humanos, prevenindo problemas como o problema do deputy confuso — quando um humano ou serviço com menores permissões consegue elevar permissões através de agentes que podem ter mais direitos.

Loops contínuos de validação: Estabelecer sistemas automatizados que continuamente verificam comportamento do agente contra padrões esperados, com procedimentos de escalação quando desvios são detectados. Auditabilidade e explicabilidade são requisitos chave para confirmar que agentes estão operando dentro dos limites pretendidos e para ajudar determinar efetividade de controle.

Integração de supervisão humana: Mesmo em sistemas altamente autônomos, manter supervisão humana significativa através de checkpoints estratégicos, relatórios comportamentais e capacidades de override manual. A supervisão humana não diminui de Escopo 1 para 4; ela simplesmente muda foco. Em Escopos 1 e 2, o requisito humano de instanciar, revisar e aprovar ações agentes é alto. Em Escopos 3 e 4 é menor, mas o requisito humano de auditar, avaliar, validar e implementar controles de segurança e operacionais mais complexos é muito maior.

Degradação graciosa: Desenhar sistemas para automaticamente reduzir níveis de autonomia quando eventos de segurança são detectados, permitindo operações continuarem seguramente enquanto operadores humanos investigam. Se agentes começarem a agir além dos limites pretendidos de seu design, comportamento anômalo é detectado, ou começam executar ações particularmente arriscadas ou sensíveis ao seu negócio, considere ter controles detetivos que automaticamente injetem restrições mais apertadas, como exigir mais HITL ou reduzir as ações que um agente pode executar.

Conclusão

A Matriz de Escopo de Segurança para IA Agêntica fornece um modelo mental estruturado e um framework para compreender e endereçar os desafios de segurança de sistemas autônomos agênticos de IA em quatro escopos distintos. Ao avaliar acuradamente seu escopo atual e implementar controles apropriados em todas as seis dimensões críticas de segurança, as organizações podem confidentemente deployar IA agêntica enquanto gerenciam a paisagem de riscos associados.

A progressão de agentes básicos e altamente constrangidos para agentes totalmente autônomos e até mesmo autodirecionados representa uma mudança fundamental em como abordamos segurança de IA. Cada escopo requer capacidades de segurança específicas, e as organizações devem construir essas capacidades sistematicamente para apoiar suas ambições agênticas de forma segura.

Próximos passos

Para implementar a Matriz de Escopo de Segurança para IA Agêntica em sua organização:

- Avalie seus casos de uso agênticos atuais e maturidade em relação aos quatro escopos para compreender seus requisitos de segurança e riscos associados.

- Integre a matriz em seus processos de procurement e SDLC.

- Identifique lacunas de capacidade nas seis dimensões de segurança para seu escopo-alvo.

- Desenvolva uma estratégia de deployment progressivo que constrói capacidades de segurança conforme você avança pelos escopos.

- Implemente monitoramento contínuo e análise comportamental apropriada para seu nível de escopo.

- Estabeleça processos de governança para progressão de escopo e validação de segurança.

- Treine seus times nos desafios de segurança únicos de cada escopo.

Você pode encontrar informações adicionais sobre a matriz de segurança agêntica em recursos específicos sobre o tema, junto com informações adicionais em tópicos de segurança de IA. Para recursos adicionais sobre asegurar workloads de IA, veja o whitepaper IA para segurança e segurança para IA: navegando oportunidades e desafios e explore plataformas propositalmente construídas para os desafios únicos de IA agêntica.

Fonte

The Agentic AI Security Scoping Matrix: A framework for securing autonomous AI systems (https://aws.amazon.com/blogs/security/the-agentic-ai-security-scoping-matrix-a-framework-for-securing-autonomous-ai-systems/)